« C’est pas moi, c’est le caillou ! » s’excuse l’enfant devant la vitre brisée… Situation anodine qui prête à sourire. Et pourtant. Quand un système de surveillance automatique de frontière ouvrira le feu et tuera des êtres humains, qui sera le responsable ? L’imprudent qui aura franchi les barrières ? La balle qui l’aura tué ? Le technicien qui aura allumé la machine ? L’ingénieur qui aura conçu le système ? L’informaticien qui aura écrit le programme ? Le politique qui aura décidé d’utiliser le dispositif ? La question n’est déjà plus théorique…

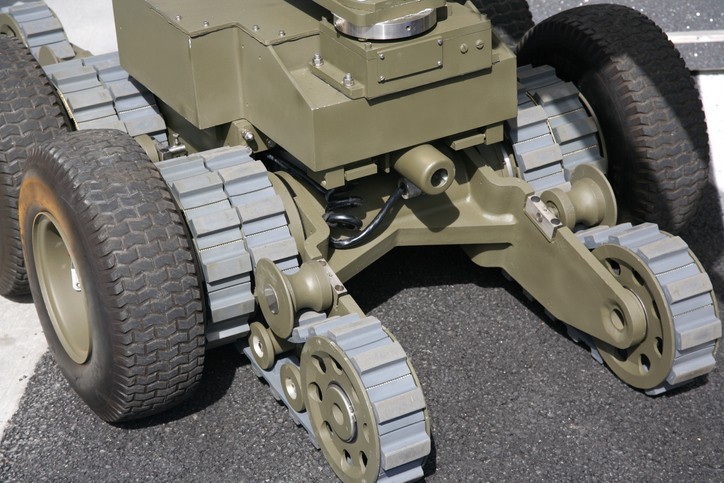

Des armes autonomes

Depuis plus de dix ans, des dispositifs de surveillance automatiques sont utilisés, par exemple à la frontière coréenne. Ils demandent encore l’autorisation d’humains pour tirer, mais disposent d’un mode automatique et pourraient donc s’en passer. On parle alors de « système d’armes létales autonomes » ou plus explicitement de « robots tueurs autonomes ». Ce domaine de recherche en intelligence artificielle est au cœur des préoccupations des fabricants d’armes (voir encadré 1), posant de graves questions éthiques (encadré 2) et techniques (encadré 3). Cependant, la peur de freiner le développement économique lié à l’intelligence artificielle fait fermer les yeux sur le danger de ses applications militaires. Mars et Mammon font toujours bon ménage.[…]